Introduction

Le streaming d’événements moderne pour des architectures fiables, scalables et temps réel.

Introduction & Objectifs

Dans un environnement où les systèmes doivent traiter des données massives en temps réel, Kafka s’impose comme la plateforme incontournable du streaming d’événements. Initialement développé chez LinkedIn, il est devenu la référence mondiale pour les architectures distribuées, microservices et pipelines temps réel.

Cette formation vous guide pas à pas, de manière progressive et orientée métier, grâce à un fil rouge concret : la digitalisation d’un système de gestion de commandes e-commerce.

Lexique essentiel

Plateforme distribuée de streaming d’événements.

Envoie des messages vers Kafka.

Lit les messages d’un topic.

Canal logique de communication.

Unité de scalabilité d’un topic.

Serveur Kafka qui stocke les messages.

Nouveau mode Kafka sans Zookeeper (plus simple et plus rapide).

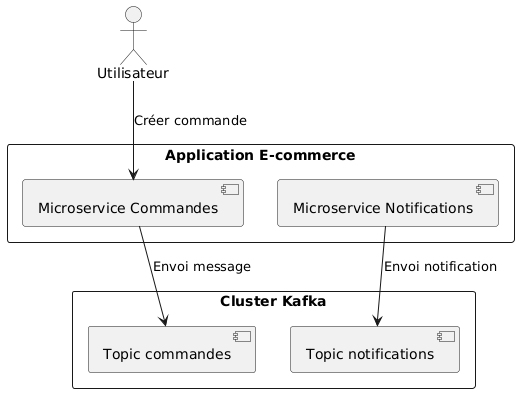

Architecture E-commerce avec Kafka

Présentation générale de Kafka dans une architecture e-commerce moderne.

Objectifs pédagogiques

- Comprendre les fondamentaux et l’architecture distribuée de Kafka.

- Installer et configurer un broker Kafka (KRaft et Zookeeper).

- Créer, publier et consommer des messages sur un topic Kafka.

- Maîtriser les partitions, la rétention, les offsets & consumer groups.

- Appliquer Kafka à des cas concrets dans l’e-commerce.

Quiz Introductif

- Q1. Kafka est un système de :

- A. Base de données relationnelle

- B. Gestion de conteneurs

- C. Streaming d’événements ✔

- Q2. Les messages Kafka sont publiés dans :

- A. Un topic ✔

- B. Un cluster

- C. Une file d’attente

Exercice : projection métier

Imaginez une application de livraison de repas :

Quels types d’événements transitent dans Kafka ?

Quels services produisent ? Quels services consomment ?

- Kafka est pensé pour la haute disponibilité → raisonnez toujours en cluster.

- Identifiez clairement vos producteurs et consommateurs dans votre domaine métier.

Résumé

Kafka permet de construire des systèmes fiables, scalables et capables de traiter de grands flux de données en temps réel. Cette formation vous accompagnera étape par étape avec une approche claire, illustrée et orientée métier.